Datenvirtualisierung – was ist das überhaupt?

Datenvirtualisierung ist ein Konzept, das im Kontext von Business Intelligence (BI) und Data Warehousing schon lange existiert. Häufig nutzen Unternehmen im Data Warehousing die klassische Datenaufbereitung mittels Datenintegration: Daten, die später in den BI-Berichten und Analysen visualisiert werden sollen, werden aus Quellsystemen (ERP-, CRM-Systemen, Excel-Tabellen, etc.) mittels Datenintegrationswerkzeugen geladen, verarbeitet (gefiltert, verknüpft, zusammengefasst, berechnet) und die fertigen Informationen werden in das Data Warehouse gespeichert.

BI-Berichte visualisieren dann diese Informationen oder die Anwender können mittels OLAP-Analysen ihren Informationsbedarf decken. Bekannte Lösungen in diesem Bereich sind zum Beispiel Informatica PowerCenter, IBM Datastage, Talend, SAS Data Integration Server und viele weitere. Die BI Scout Marktübersicht listet unter -> Datenmanagement -> Datenintegration insgesamt 118 Lösungen.

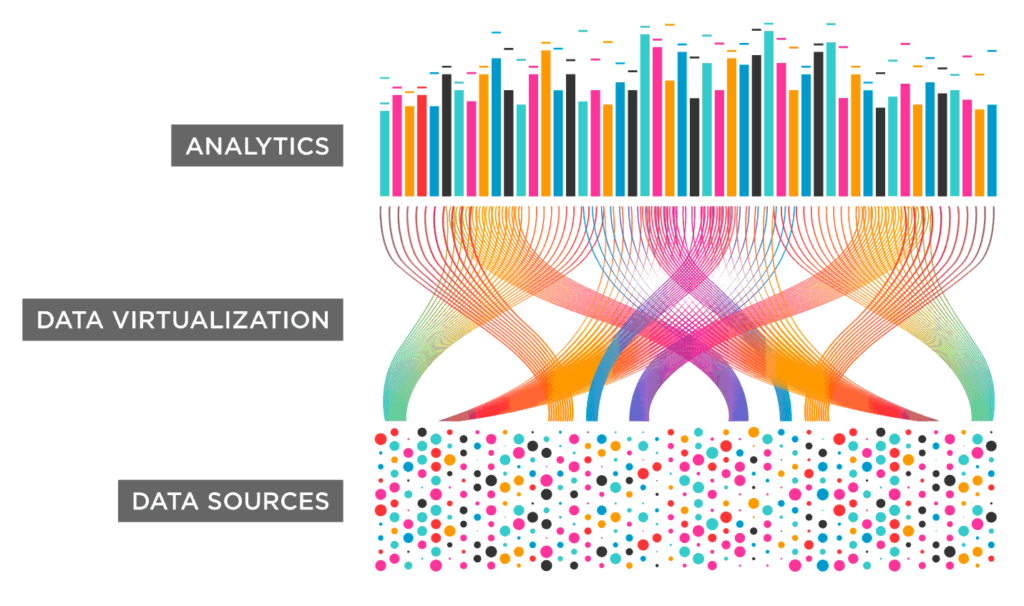

Bei der Datenvirtualisierung geht es um die logische Datenintegration von Daten zum Abfragezeitpunkt – das Datenvirtualisierungswerkzeug sieht nach außen aus wie ein Data Warehouse, also Tabellen, die mit SQL durch die BI- und Analysewerkzeuge gelesen werden können.

Intern hält das DV-Werkzeug jedoch nicht die Daten, sondern holt sie sich „on-Demand“ aus den Quellsystemen, zum Beispiel wenn für einen BI-Bericht gewisse Kennzahlen benötigt werden (siehe auch BI Scout Marktübersicht -> Datenmanagement -> Föderation).

Was sind die Vorteile von Datenvirtualisierung?

Der Hauptvorteil liegt darin, dass Unternehmen mittels DV sehr schnell neue BI-Anforderungen umsetzen können: man muss keine Tabellen im Data Warehouse anlegen oder komplexe Datentransformationsstrecken im Datenintegrationswerkzeug konzipieren und entwickeln.

Das Design der Tabellen für den Anwender und mögliche Datenaufbereitungsschritte werden direkt im DV-Werkzeug definiert. Änderungen, zum Beispiel in Form von neuen Datenquellen oder zusätzlichen Spalten können vergleichsweise schnell hinzugefügt werden.

Was sind die Nachteile von Datenvirtualisierung?

Bisher war Geschwindigkeit oft ein großes Problem: Wenn beispielsweise ein Business-Intelligence-Tool Daten von der Datenvirtualisierungsplattform abruft, kann der Bericht für gewöhnlich erst dann erzeugt werden, wenn das langsamste Quellsystem geliefert hat.

Zudem sind viele Quellsysteme nicht für analytische Massenabfragen ausgelegt: Greift das DV-Werkzeug beispielsweise mit einer Abfrage über die Umsatzzahlen der letzten fünf Jahre direkt im laufenden Betrieb auf die Daten im ERP-System zu, so kann dies zu Problemen in der Systemstabilität und Verfügbarkeit der operativen ERP-Software führen.

„Diese Herausforderungen sind natürlich bei vielen Anbietern bekannt und werden oftmals thematisiert. Wir haben sie jedoch bereits in den Griff bekommen und gute, schnell umzusetzende Lösungen parat”, erklärt Dr. Nick Golovin, CEO von DataVirtuality, einem führenden Anbieter von Datenvirtualisierungslösungen, auf die Nachteile angesprochen.

Marktgröße und Implementierungsrate

Datenvirtualisierung ist in den USA eine etablierte Technologie. Bereits vor zehn Jahren setzten Early Adopters Projekte um, vor allem im Finanzsektor. Die dann aufkommende Big-Data-Diskussion hat den Markt verunsichert und die DV-Verbreitung von DV vor allem in Deutschland gebremst.

Inzwischen wird DV wieder zunehmend besprochen. Die unabhängigen Analysten von BARC sehen das Thema aktuell immer öfter in Beratungsprojekten und begleiten immer mehr Proof of Concepts in Unternehmen aus der DACH-Region.

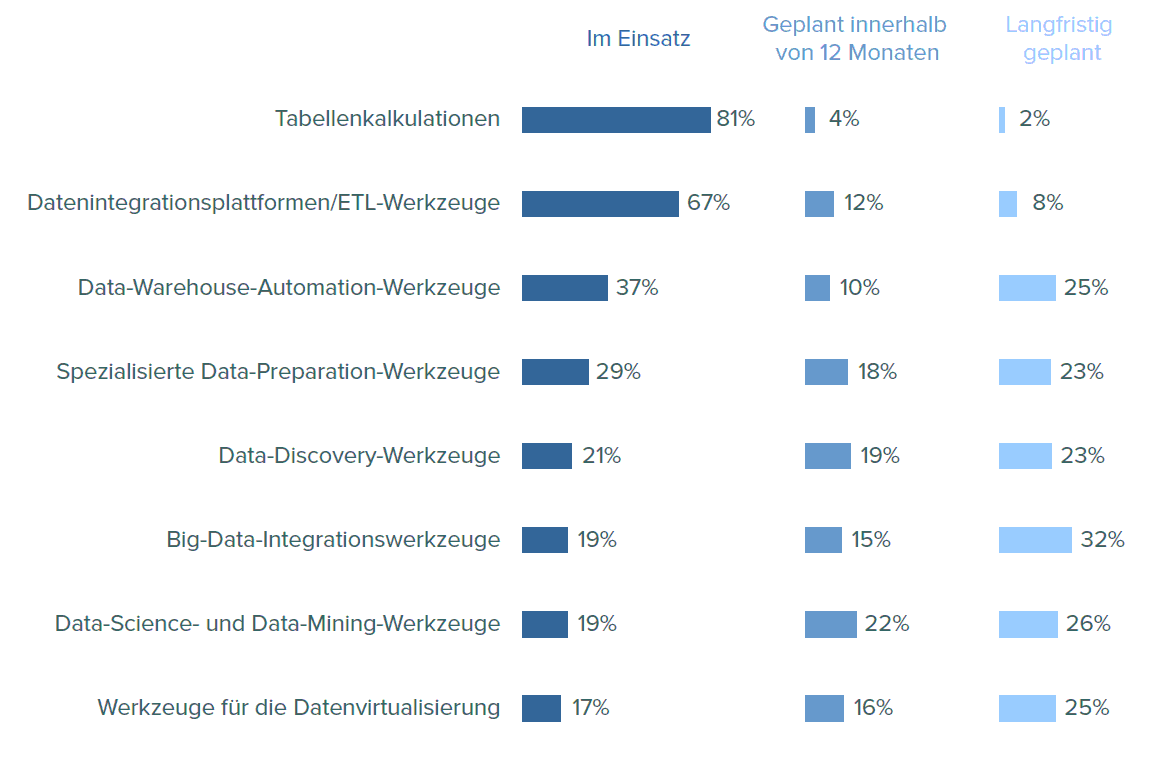

Mehrere Analystenberichte 2017 zeigen einen verstärkten Einsatz der Datenvirtualisierung:

- In der BARC-Studie „Data Preparation im Fachbereich in der DACH-Region“ wurden 265 Teilnehmer gefragt: „Welche Werkzeuge werden in Ihrem Unternehmen für Data Preparation eingesetzt?“ 17 Prozent hatten Werkzeuge für Datenvirtualisierung bereits im Einsatz, 16 Prozent planen den Einsatz innerhalb der nächsten zwölf Monate und weitere 25 Prozent den langrfristigen Einsatz (siehe Abbildung).

- Gartner schätzt, dass bis zum Jahr 2020 in den USA 50 Prozent der Unternehmen eine Form der Datenvirtualisierung als eine Produktionsoption für die Datenintegration implementieren werden.

- In einer Umfrage aus dem Jahr 2017 mit über 2100 Teilnehmern stellte Forrester fest, dass 56 Prozent der Befragten die Datenvirtualisierung bereits implementierten und / oder vorhandene Initiativen für Datenvirtualisierung erweiterten. Weitere 20 Prozent planen die Umsetzung in den nächsten zwölf Monaten.

Aktuelle Marktentwicklungen

Auf Anbieterseite sind in DACH vor allem DataVirtuality, Denodo und TIBCO in den letzten Jahren stark als Vorreiter der Datenvirtualisierungstechnologie in Vorschein getreten.

Das 2012 gegründete deutsche Unternehmen DataVirtuality bietet eine SQL-orientiere Datenvirtualisierungslösung und adressiert insbesondere die Fachbereiche.

Geschäftsführer Dr. Nick Golovin meint: „Virtualisierung heißt, dass man die Daten nutzen kann, ohne sich groß darüber Gedanken zu machen wo sie wirklich liegen. DataVirtuality legt eine virtuelle Schicht über alle Datensilos, sodass diese verschwinden. Die Daten werden aus den Speicherorten abstrahiert. Früher hat man das mit ETL-Tools gemacht. Das ist oft ein aufwändiger Prozess.“

Lakshmi Randall, Director of Product Marketing für Denodo, sieht in Deutschland und allgemein eine höhere Implementierungsrate: „Die Einführung neuer Technologien in bestehende Infrastrukturen hat häufig unternehmenspolitische Implikationen. Da die Datenlandschaft jedoch immer komplexer wird, müssen Unternehmen ihre Dateninfrastruktur modernisieren. Und wenn sie einmal verstanden haben, wie DV die Lücke zwischen alt und neu schließen kann, sind sie offener dafür, auch in Deutschland.“

Um den einstigen Primus Composite Software war es die letzten Jahre still geworden. Das Unternehmen wurde 2013 von Cisco übernommen und eher im Rahmen der Cisco-Produktportfolios eingesetzt und vertrieben (IT-Infrastruktur). Im November 2017 hat TIBCO Composite Software übernommen. TIBCO schärft damit sein Profil im Bereich Datenmanagement und wird sicherlich die Datenvirtualisierungstechnologie stärker im umfangreichen BI-, Analytics- und Advanced-Analytics-Portfolio vermarkten.

Die Erfahrung ist da: TIBCO hat Composite Software bereits lange Jahre als OEM (Original Equipment Manufacturer) genutzt. Robert Eve, Senior Director TiBCO und früherer CMO von Composite sieht Datenvirtualisierung als die Antwort auf Datensilos (z.B. in Big-Data- oder Cloud-Lösungen). „Aufgrund der Datensilos gibt es einen größeren Bedarf nach Lösungen für einfachen Zugriff auf diese Daten“ (lesen Sie hier das Ebook „Data Virtualization“ von Robert Eve kostenfrei).

Weitere Ansätze und Lösungen im Bereich Datenvirtualisierung:

- SAP HANA enthält mit der Funktion „Smart Data Accesss“ auch eine Möglichkeit externe Datenquellen an ihre Plattform anzuschließen.

- Klassische Datenbanken (Oracle, IBM, etc.) bieten über Konstrukte wie virtuelle oder externe Tabellen schon seit sehr langer Zeit ähnliche Ansätze wie DV-Werkzeuge.

- Datenintegrationssoftware kann zwar oft ihre Datenintegrationsservices nicht als SQL-View nach außen zur Verfügung stellen, wohl aber als API oder Service, der dann auch ad hoc gestartet werden kann, um Ergebnisse bspw. als CSV-Datei zu generieren.

- Auch Hersteller von NoSQL-Datenbanken (Not only SQL Datenbanken) greifen Ansätze der DV auf. DataWerks beispielsweise stellt eine Datenvirtualisierungstechnologie bereit, die intern NoSQL-Technik nutzt, um die relevanten Informationen aus den Datenquellen zu lesen (häufig im Kontext von Massendaten im Bereich Sensordaten, Social & Maschinendaten), zu puffern und Informationen so besonders schnell an die anfragende Anwendung zu übergeben (ohne eben auf die eigentlichen Datenquellen zu warten).

Fazit

Datenvirtualisierungstechnologie bietet aufgrund ihres agilen und flexiblen Ansatzes eine interessante Herangehensweise für Unternehmen, um mit zunehmenden Datenquellen und wachsenden Datenmengen umzugehen. Nicht nur klassische Business-Intelligence-Umgebungen können durch geschickte Nutzung von Datenvirtualisierung im Data-Warehouse-Stack (Staging Area, Data Warehouse, Data Marts) profitieren.

Auch datengetriebene Fachbereiche, wie Marketing- oder Data-Science-Labs können für die Umsetzung ihrer Projekte profitieren. Es wird interessant zu beobachten, wie die Software-Hersteller mit langsamen oder kritischen Quellsystemen umgehen und wie sie komplexere Datenaufbereitungs- und Datenqualitätsanforderungen umsetzen wollen.