Eines unserer BARC Webinare drehte sich um das Thema Data Catalogs. Das bewährte Konzept sieht vor, dass verschiedene Softwareanbieter eine Aufgabenstellung erhalten und 20 Minuten Zeit haben, diese zu beantworten. Dabei sollen die Anbieter möglichst auf Folien verzichten und ihre Werkzeuge direkt präsentieren. Das Format ist überwiegend interaktiv, sodass Teilnehmer Fragen stellen können.

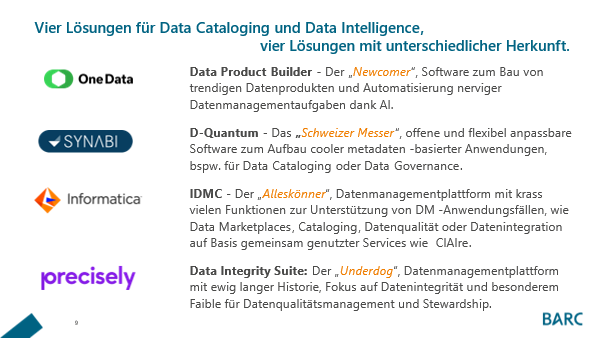

In diesem Webinar traten One Data, Synabi, Precisely und Informatica gegeneinander an.

Die Aufgabe

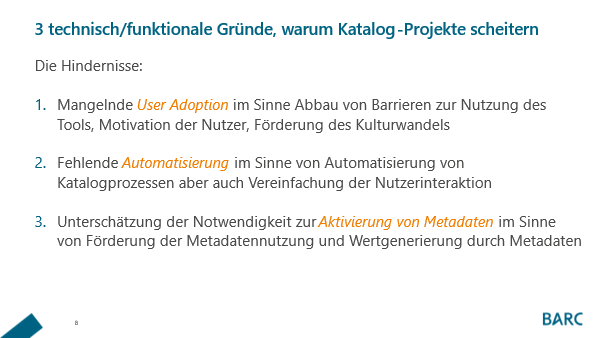

Unsere Zielsetzung war es, die Produkte möglichst vergleichbar gegenüberzustellen. Daher habe ich als Moderator im Vorfeld entsprechende Aufgabenstellungen definiert, um die Anbieter mit den aus unserer Sicht größten Herausforderungen in Data Catalog Projekten zu konfrontieren.

Die Kontrahenten

Besonders spannend waren die unterschiedliche Herkunft und Positionierung der Anbieter. Davon haben wir uns auch unterschiedliche Lösungsansätze versprochen. Zur besseren Einordnung haben wir zu Anfang die Anbieter kurz skizziert.

Dieser Eindruck hat sich im Laufe des Webinars bestätigt. So haben wir

- von One Data den Fokus auf den Data Product Lifecycle gesehen und Datenprodukte gebaut,

- von Synabi anhand eines Beispiels die Herkunft und Implikation schlechter Daten in einem Jahresbericht untersucht und nachvollzogen,

- von Precisely einiges über Datenqualität und Data Observability gelernt

- und von Informatica vor allem Data Marketplace Funktionen und das neue GPT Modul kennengelernt.

Highlights im Webinar

Die gestellten Aufgaben wurden unterschiedlich adressiert. In Summe erhielten die Teilnehmer einen guten Überblick von Spielvarianten im Data Cataloging. Interessant war, dass sich die Lücke von Metadaten zu Daten zu schließen scheint und Datenverarbeitung mehr Gewicht bekommt. In den gezeigten Ansätzen fällt es daher schwer, von Werkzeugen zu reden, die „nur“ Metadaten verarbeiten. So konnten die Zuschauer verfolgen, wie Daten zur Bereitstellung aufbereitet/bereinigt werden können – sei es mithilfe von Data Pipelines, Data Preparation Funktionen, Steuerung des Access Management oder aber durch einen Befehl and künstliche Intelligenz.

Weiterhin auffällig war die Geschwindigkeit in der Weiterentwicklung von Funktionen. Wir führen diese Webinare jährlich durch und so bietet sich eine gute Vergleichsmöglichkeit. So können wir beobachten, dass sich sowohl von den Funktionen, der User Experience, als auch von den Workflows einiges getan hat. Highlight-Features in diesem Webinar sind aus meiner Sicht die bereits vorhandene GPT-Implementierung, Data Observability Funktionen, die Ansätze zur Abbildung und Bereitstellung von Data Products, neue moderne User Interfaces, sowie auch neue Arten, sich im Datengewebe zu bewegen.

Zuletzt nochmals einen Dank an die Sprecher: sie waren alle top vorbereitet und hoch motiviert. Ein „Runterleiern“ von Slides gab es in diesem Webinar nicht. Alle Vorträge waren sehr gut strukturiert, mithilfe von Beispielen bzw. Problemen fiktiver Unternehmen gut nachvollziehbar und aus unterschiedlichen Nutzerperspektiven gut erzählt. So konnte der Zuhörer auch ein Gefühlt dafür entwickeln, wer alles in einem Catalog-Prozess involviert ist und wie solch ein Prozess überhaupt aussehen kann.

Eine kleine Schattenseite gab es dennoch: mir fehlten ein paar Teilaspekte, die ich gerne gesehen hätte und die wohl der knappen Zeit zum Opfer gefallen sind. Darunter finden sich:

- Wie kann ich als Nutzer auf die Kataloginhalte zugreifen?

- Wie einfach und nahtlos kann ich auf den Katalog aus meinen Workflows, aus meinen Tools zugreifen?

Diese Fragen wurde nicht wirklich beantwortet und zählen für mich zu den wichtigsten, wenn wir über User Adoption reden.

Auch das Thema Aktivierung von Metadaten kam mir ein wenig zu kurz oder wurde nicht gut hervorgehoben. In Ausschnitten sahen die Zuschauer, wie Metadaten Aktionen auslösen können (bspw. im Rahmen der Data Observability), aber das Thema bietet noch mehr Potential.

Insgesamt überwiegen die positiven Aspekte deutlich und im Webinar bekam der Zuhörer einen guten Eindruck von der Leistungsfähigkeit der Werkzeuge sowie wertvolle Informationen darüber, wie oben genannte Hindernisse adressiert werden können.

Neben den Werkzeug-Themen fand sich noch Zeit, allgemeinen Fragen in den Q&A Sessions auf den Grund zu gehen. So wurde beispielsweise geklärt, was Datenprodukte sind oder Start-Tipps für die Implementierung gegeben. So habe ich u.a. gelernt, dass bei Synabi Datenprodukte auch „Data Collections“ genannt werden. 😉

Meine Top 3 Takeaways aus dem Webinar

- Data Products beeinflussen stark die Entwicklung von Data Intelligence Plattformen, Data Catalogs oder Data Marketplaces.

- Rein metadaten-basierte Werkzeuge reichen nicht mehr aus. Self-Service Datenzugriff muss tiefgehender unterstützt werden. Metadaten sind zu aktivieren.

- AI im Allgemeinen und LLM im Speziellen verändern die Art und Weise Unternehmensdaten bereitzustellen, zu konsumieren und zu schützen.

Wer mehr erfahren will ist herzlich eingeladen sich das Webinar on-demand anzuschauen.

Wer mehr zu Datenkatalogen erfahren will, schaut bitte hier, weitere Informationen zu Data Intelligence gibt es hier.

Ganz heiß auch: der aktuelle BARC Score Data Intelligence Platforms 2024.

Nachfolgend fassen wir die Präsentationen der einzelnen Anbieter noch einmal kurz zusammen:

One Data

Übersicht und Herausforderungen

One Data präsentierte eine innovative Herangehensweise an das Data Management, indem sie sich mit dem fiktiven Unternehmen Spacelink Dynamics befassten. Dieses Unternehmen stand vor drei Hauptherausforderungen:

- Datenintegration: Die Zusammenführung von Datensilos stellte eine erhebliche Herausforderung dar.

- Datenqualität: Selbst wenn alle Daten bekannt sind, bleibt die Bewertung der Datenqualität schwierig.

- Compliance: In einem stark regulierten Sektor galten erhöhte Anforderungen.

Lösungsansatz und Funktionen

One Data behauptete, diese Herausforderungen zu überwinden und wertvolle Zeit zurückzugewinnen. Ihr Funktionsumfang umfasste:

- Integration: Nahtlose Zusammenführung unterschiedlicher Datenquellen.

- Qualität: Sicherstellung und Überwachung der Datenqualität.

- Bereitstellung: Effiziente Datenaufbereitung und -bereitstellung.

Demo-Highlights

- Wabenstruktur: Visuelle Darstellung der Daten.

- Suche: Effektive Suchfunktionen für schnelles Auffinden relevanter Daten.

- Governance-Prozesse: Verwaltung von Zugriffsanfragen mittels Kanban-Boards.

- DQ-Ansicht auf Daten: Rollenbasierte Sichten und DQ-Overlay für eine umfassende Datenqualität.

- Projektbereiche: Dedizierte Räume zur Erstellung von Datenprodukten.

Mehrwert

- Kuratiert und Verwendbar: Datenprodukte liefern kuratierten Mehrwert und sind direkt verwendbar.

- Fragen und Regeln: Eigenes Regelwerk im Hintergrund zur Überprüfung der Datenqualität.

- Access Management: Eigenständige Verwaltung des Zugriffs, zukünftig plattformübergreifend koordinierbar.

Fazit

One Data nahm die Teilnehmer mit auf eine Reise und demonstrierte eindrucksvoll, wie durch innovative Ansätze im Data Management erhebliche Zeit- und Ressourceneinsparungen möglich sind.

Synabi

Präsentation und Beispiel

Synabi wurde von zwei Sprechern vertreten. Thorsten half Katharina dabei, Unregelmäßigkeiten im Jahres-Brutto-Umsatzbericht aufzudecken. Die Ursache lag in der Datenqualität.

- Lineage: Rückverfolgung der Datenherkunft und -verwendung.

- D-Quantum: Unterstützung durch die D-Quantum-Plattform bei der Suche und Bestellung von Datenprodukten.

Datenprodukte und Flexibilität

- Data Collection: Flexible Sammlung von Assets, die auf konkrete Anwendungsfälle ausgerichtet sind.

- Nutzungszweck: Wichtig ist ein klarer Use Case, der die Nutzung der Daten definiert.

Fazit

Synabi zeigte detailliert, wie die Datenqualität die Genauigkeit von Berichten beeinflussen kann und wie flexible Datenkollektionen und klare Anwendungsfälle den Mehrwert von Datenprodukten steigern können.

Precisely

Datenintegrität und Genauigkeit

Precisely stellte die Datenintegrität in den Mittelpunkt und betonte die Wichtigkeit von:

- Genauigkeit: Höchste Präzision in den Daten.

- Kontext und Konsistenz: Sicherstellung, dass Daten im richtigen Kontext konsistent genutzt werden.

Data Integrity Suite

- Mehr als nur ein Katalog: Umfassende Suite zur Datenintegrität, einschließlich der Darstellung anhand von Rollen.

- DQ-Bereinigungen: Direkte Bereinigungen im Workflow.

Data Quality vs. Data Observability

- Prüfung gegen bestehende Regeln: Überwachung und Anpassung von Datenqualität.

- Überwachung durch KI: Automatische Erkennung von Anomalien in Tabellen (Änderung der Menge, Inhalte, Schema oder das Verschwinden von Tabellen).

Fazit

Precisely überzeugte durch eine umfassende Data Integrity Suite, die weit über traditionelle Katalogfunktionen hinausgeht und sowohl Datenqualität als auch Data Observability integriert.

Informatica

Plattform und Services

Informatica bietet eine breite, modular aufgebaute Plattform mit:

- DM Services: Basierend auf gemeinsamen Services wie AI und Konnektivität zur Automatisierung.

- Journey of Data Products: Datenprodukte standen im Mittelpunkt.

Rollen und Regeln

- Unterschiedliche Rollen: Unterstützung verschiedener Rollen in der Datenverarbeitung.

- DQ-Regelerstellung: Erstellung von Datenqualitätsregeln in natürlicher Sprache.

Marktplatz und AI

- Claire GPT: Unterstützt bei der Lineage-Analyse und Datenvorbereitung.

- Co>pilot: Kennt den Startpunkt von COVID und kann direkt zur Datenvorbereitung springen.

Fazit

Informatica beeindruckte durch eine breite Palette an Funktionen, die von der Datenqualitätsregelung bis zur Unterstützung durch künstliche Intelligenz reichen, und bot eine umfassende Plattform für das Datenmanagement.