Der Begriff Künstliche Intelligenz (KI, engl. artificial intelligence, AI) als Teilgebiet der Informatik umfasst ein weites Feld. Im Kern bei der Umsetzung konkreter Aufgabenstellungen steht dabei das Maschinelle Lernen (engl. Machine Learning), das gemäß BARC Definition und Strukturierung Teil der Advanced Analytics ist.

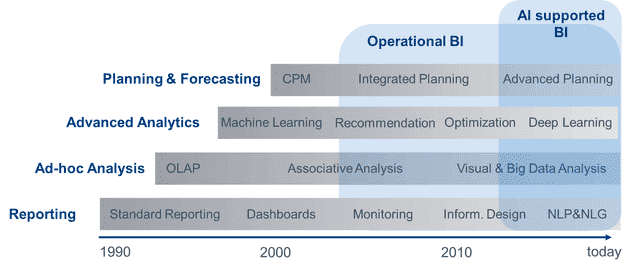

Advanced Analytics ist schon seit den Diskussionen um Data Mining in den 1990er Jahren Teil der Business Intelligence (BI), allerdings bisher immer als kleiner Teilbereich in speziellen Anwendungen für sehr eingeschränkte Nutzungsszenarien. Die Zukunft das KI-Marktes ist rosig: Das Marktvolumen wurde 2016 bereits mit 643,7 Millionen US-Dollar beziffert. 2017 soll es sich laut den Marktforschern von Tractica verdoppeln und bis 2025 auf 36,8 Milliarden US-Dollar anwachsen.

AI FIRST

„Mobile first to AI first“ verkündete Google CEO Sundar Pichai auf ihrer I/O Entwicklerkonferenz im Mai 2017 (siehe Video). Google und viele andere Unternehmen der Technologiebranche sehen im Einsatz von Künstlicher Intelligenz die nächste große Entwicklungsstufe der Informationstechnologie. „AI First“ folgt „Mobile First“, dem dominierenden Paradigma von Googles Softwareentwicklung der letzten Jahre, bei dem das mobile Endgerät als fundamentale Veränderung der Nutzerschnittstelle und damit möglicher Services im Vordergrund gestanden hat.

Mit dem Laden des Videos akzeptieren Sie die Datenschutzerklärung von YouTube.

Mehr erfahren

Google überarbeitet nun alle seine Produkte und internen Prozesse auf Basis der Fragestellung, wo Machine Learning einen Beitrag leisten kann, Anwenderprobleme zu lösen. Das „AI first“-Paradigma ist aber nicht nur für Softwareunternehmen relevant. Die Fragestellung nach neuen Produkten, Geschäftsmodellen und Prozessverbesserungen durch den Einsatz von KI stellt sich für jedes Unternehmen, wodurch „AI first“ einen universellen Charakter bekommt.

Advanced Analytics

Advanced Analytics wird schon seit den 90er Jahren als Teil der Business Intelligence (BI) verstanden, aber erst jetzt richtig relevant. Erst seit kurzem sind die notwendigen Rechenleistungen zu niedrigen Kosten für Aufbau, Test und Vergleich von Modellen verfügbar, ebenso wie die notwendigen Datenmengen zum Training von Modellen. Außerdem treibt die steigende strategische Bedeutung der Digitalisierung in Unternehmen die Nachfrage.

KI-Verfahren wie statistische Datenanalyse und Machine Learning sind ergänzende Angebote zu klassischen BI-Verfahren. Die Vorgehensweise unterscheidet sich: Klassische BI für Reporting und Ad-hoc-Analyse hat einen wesentlichen Fokus auf die Bereitstellung von Daten in einer hohen Qualität, was zum Teil auf Kosten der Geschwindigkeit und Agilität in der Umsetzung neuer Anforderungen geht.

In einem „Factory“-Ansatz werden Daten und Reports mit einem definierten Service-Level hinsichtlich Lieferzeitpunkt und Inhalt zu möglichst geringen Kosten durch Automatisierung geliefert. Ein freies Experimentieren mit Daten, z.B. im Sinne einer „Data Discovery“, wird hier eher dem Anwender als „Self-Service“ überlassen. Das Bild des Datenlabors (Data Lab) passt hier gut. Das Ziel der explorativen BI ist das möglichst schnelle und häufige Ausprobieren verschiedener Ansätze und Verfahren der fortgeschrittenen Datenanalyse um Modelle zur Entscheidungsunterstützung oder -automatisierung zu generieren.

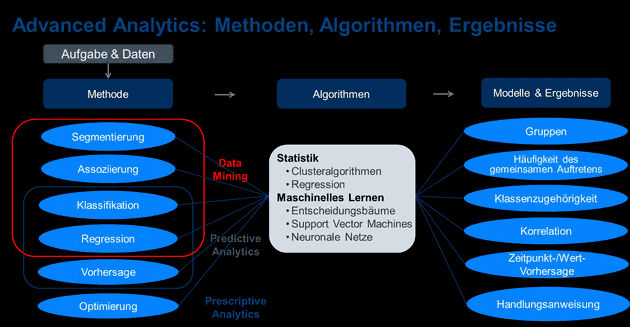

Dabei spielt der zuletzt viel beschworene „Data Scientist“ eine entscheidende Rolle. Diese Rolle des Datenanalyseexperten ist in gewisser Hinsicht neu und wird am sinnvollsten Zusammenspiel mit den Kompetenzen des Data Engineer, Data Artist/Visualisierungsexperten und des Business Analysten eingesetzt. Der Data Scientist nutzt die vom Data Engineer aufbereiteten Daten, um Algorithmen zur Modellbildung für verschiedene Methoden und Ziele der Datenanalyse wie Segmentierung, Klassifikation oder Vorhersage von Daten zu erstellen (siehe Abbildung 2).

Die nächste Stufe der Business Intelligence

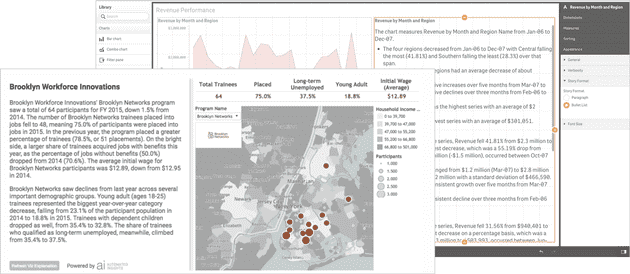

KI/Machine Learning ist aber nicht nur eine Erweiterung des Funktionsspektrums der Business Intelligence, sondern hat auch einen Einfluss auf alle anderen Verfahren der Business Intelligence und auf die Fähigkeiten von BI-Software insgesamt. So können die musterentdeckenden Verfahren der Künstlichen Intelligenz Fachanwender in allen Bereichen der BI unterstützen. So ändert sich derzeit die „Mensch-Maschine-Schnittstelle“ und wird um die Sprachinteraktion ergänzt. Spracheingabe (Natural Language Processing, NLP) und -ausgabe (Natural Language Generation, NLG) sind besonders wirkungsvoll, wenn sie mit „intelligenten“ Assistenten verbunden werden, die Abfragen in ihren Kontext setzen können, Empfehlungen für die nächsten Schritte der Datenanalyse geben oder auch interessante Konstellationen in Daten selbstständig entdecken.

Beispiele für den Einsatz von KI gibt es inzwischen in allen Bereichen der Business Intelligence:

- Reporting/Dashboarding: Sprachinteraktion zum Aufruf von Informationen/Berichten, Empfehlung von Grafiktypen bei der Berichtserstellung, Natural Language Generation zur Erzeugung von natürlichsprachigen Berichten auf Basis von Berichtsdaten.

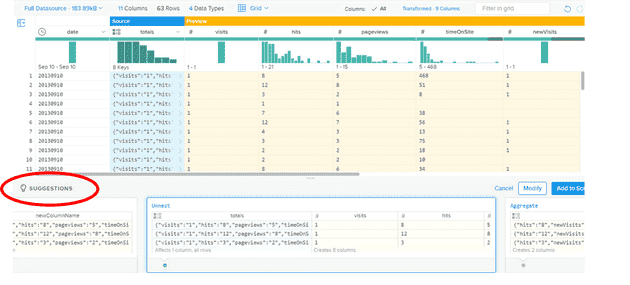

- Ad-hoc-Analyse und Data Discovery: Empfehlungen für Analysepfade und Analysemethoden, Identifikation von Mustern und Auffälligkeiten in Daten, Unterstützung bei der Datenaufbereitung und Datenqualitätsverbesserung im Rahmen der Datenintegration/ Data Preparation für Fachanwender.

- Planung: Automatisiertes Forecasting, Treiberidentifikation und -berechnung

- Advanced Analytics: Identifikation von Korrelationen/Erklärungsgehalt, Empfehlung und Validierung von Analysemethoden und Modellen.

Unterstützung des Datenmanagements durch KI

Im Datenmanagementumfeld unterstützt Künstliche Intelligenz moderne, effiziente Big-Data-Lösungen.

Einige Einsatzbereiche von KI im Datenmanagement sind:

- Automatisiertes Tagging und Katalogisierung von Daten

- Informationsgewinnung aus Text-, Bild-, Video-Daten

- „Data Preparation“: Vorschläge und semi-autonome Umsetzung von Mappings, Joins, Datenqualitätsverbesserung etc.

Durch den gezielten Einsatz von Machine Learning im Datenmanagement kann eine höhere Effizienz durch Automatisierung von Routinetätigkeiten erzielt werden. Die geringere Abhängigkeit von Experten zur Bereitstellung von Daten macht mehr Self-Service durch Fachanwender möglich. Außerdem sollten nutzbare Daten für Berichtswesen und Analyse schneller zur Verfügung gestellt werden können.

Autonome Software

Je mehr Prozesse Software eigenständig, zuverlässig und möglichst auch nachvollziehbar übernehmen kann, desto effizienter kann ein Softwareeinsatz erfolgen. Autonome Software wird momentan mit folgenden Zielen entwickelt:

- Self-Managing/Self-Configuring: Eigenverwaltung und Konfiguration

- Self-Tuning/Self-Adapting: Eigenständige Anpassung und Optimierung auf Basis der bisherigen Ergebnisse und Veränderung der Nutzung

- Self-Monitoring/Self-Healing: Eigenständige Überwachung und Reparatur fehlerhafter Prozesse

- Self-Protecting: Selbstschutz vor Missbrauch, unberechtigten Zugriff, Nutzerfehlern etc.

Dadurch sollte der Administrationsaufwand verringert werden: Die frei werdenden Ressourcen können für andere, nützlichere Tätigkeiten verwendet werden und Business Intelligence Software wird durch autonome Lösungen verfügbarer und verlässlicher. Außerdem wird die Abhängigkeit von Expertenwissen zur Sicherstellung der bestmöglichen Performance und Skalierbarkeit einer Lösung geringer.

Fazit

Der durchdachte und gezielte Einsatz von KI-Verfahren wie Machine Learning hat das Potential Geschäftsmodelle, Produkte und Prozesse zu verbessern. Dabei wird die Business Intelligence weiterhin eine entscheidende Rolle spielen, denn Advanced-Analytics-Verfahren sind Kern von KI, aber auch schon lange Teil der BI.

Business Intelligence profitiert von Advanced Analytics, indem einerseits leistungsfähigere analytische Verfahren angeboten werden können. Andererseits werden Reporting, Analyse und Planung aber auch das Datenmanagement durch in der Software eingebettete KI-Verfahren immer besser unterstützt, bis hin zur autonomen Ausführung bestimmter Datenmanagement- und -analyseaufgaben durch die Software.