Kürzlich hatten wir Gelegenheit an der Post Quantum Cryptography (PQC) Konferenz von Fraunhofer AISEC teilzunehmen. Dabei ging es im Wesentlichen um die Frage, welche Gefahren für Daten in Unternehmen in Zukunft, aber auch schon heute bestehen und zwingend auf die CIO-Agenda gehören.

Um es in einem Satz zusammenzufassen besteht die Gefahr durch potentielle Angreifer in „Store Now, Decrypt Later“. Dass Hacker-Angriffe kontinuierlich passieren und gelegentlich auch zu „sichtbaren Erfolgen“ führen, ist jedem Datenverantwortlichen bewusst. Die weitaus größere Bedrohung für Unternehmen besteht jedoch darin, dass Daten unbemerkt aus Unternehmensumgebungen kopiert werden („invisible hacking“) und zu einem späteren Zeitpunkt mittels Quanten-Computing entschlüsselt werden. Man mag hier einwenden, dass die Daten von heute zum Zeitpunkt einer potentiell sehr viel späteren Dekodierung nicht mehr relevant sein können. Dieses Risiko sollten die Verantwortlichen jedoch nicht eingehen.

Quanten-Computing befindet sich vielfach noch im experimentellen Stadium, was sich unter anderem darin ausdrückt, dass die Entwickler immer noch auf der Suche nach den richtigen Aufgaben sind, die sich mit Quanten-Computing besser (oder überhaupt erst lösen lassen) als mit klassischen binären Computern. Darüber hinaus scheint sich noch nicht klar abzuzeichnen, welche Quanten-Computing-Basistechnologie letztlich diejenige sein wird, auf der dann alle Weiterentwicklungen des Quanten-Computing aufbauen werden.

Derzeit existieren verschiedene Ansätze für Quanten-Computing (z.B. superconducting qubits, ion trap qubits, quantum dots qubits, topological qubits, color center qubits on SiC, optical tweezers-based qubits, photonic quibits, …). Einige davon sind vielversprechender, andere weniger. So eignen sich Quanten-Computer, die auf Annealing-Technik basieren, praktisch nur für sehr spezielle Optimierungsaufgaben, für die sie explizit entwickelt wurden. Sie sind aber weitgehend ungeeignet zur Lösung von Kryptographie-Aufgaben. Am weitesten entwickelt sind derzeit Quanten-Computing-Ansätze, die auf 2D-Transmonen basieren, die in supraleitenden Qubits zum Einsatz kommen. Insbesondere Google und IBM setzen auf diese Technologie. Die wesentliche Entwicklungsrichtung besteht derzeit darin, Error-Correction-Funktionen so zu verbessern, dass das immer vorhandene Rauschen in den Zuständen der Qubits beherrschbar wird, um zuverlässig reproduzierbare Ergebnisse zu erzielen.

Auf der anderen Seite stehen Ion-Traps-Ansätze (Ionenfallen), die zunächst als Lösung für viele Probleme des Quanten-Computing galten, bei denen sich aber herausgestellt hat, dass die Zahl der Störungen mit der Zahl der erforderlichen Ionen überproportional ansteigt; d.h., dieser Ansatz ist derzeit nicht gut skalierbar. Relativ neu ist dagegen eine Technik, die auf Rydberg-Atomen basiert. Dabei handelt es sich um Atome, die sich in sehr hohen Anregungszuständen befinden (bis kurz vor einer Ionisierung). Im Moment wird dies als eine neue vielversprechende Technologie angesehen.

Wie man sieht, gibt es sehr unterschiedliche technologische Ansätze zur Realisierung eines frei programmierbaren Quantencomputers. Welche der Basistechnologien sich letztlich durchsetzen wird, lässt sich derzeit nicht mit Sicherheit vorhersagen. Es können überraschend auch immer wieder neue Basistechnologien auftauchen, die im Moment eine verlässliche Prognose unmöglich machen. Aus diesem Grund ist es auch nicht verwunderlich, dass es (noch) kein Moore‘sches Gesetz für die Entwicklung der Leistungsfähigkeit von Quantencomputern gibt, da es in der aktuellen Entwicklungsphase immer wieder zu Diskontinuitäten kommen kann. Entwicklungsvorhersagen à la Moore‘s Law können nur in konvergierten Technologieumgebungen wie der siliziumbasierten Prozessor- und Speichertechnologie angewendet werden. An diesem Punkt sind wir beim Quanten-Computing aber noch nicht angelangt, da es immer wieder schnell zu neuen Durchbrüchen und auch kompletten Richtungswechseln in Forschung und Entwicklung kommen kann.

Ansonsten ist derzeit davon auszugehen, dass kommerziell verfügbare Quanten-Computer-Systeme in spätestens zehn Jahren allgemein verfügbar sein werden. Die Vorhersage „in zehn Jahren“ wird zwar schon seit einiger Zeit Jahr für Jahr von der Forschungsgemeinde postuliert; da es aber inzwischen Quantencomputer der zweiten Generation gibt, die bereits in definierten Szenarien zum Einsatz kommen, erscheint die Prognose auch vor dem Hintergrund der folgenden Überlegungen tragfähig:

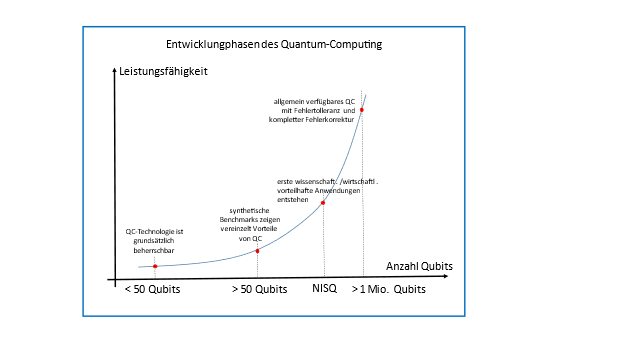

Man kann die Entwicklung von Quanten-Computing grob in vier Zeitabschnitte einteilen (insbesondere wenn man die Annealing-Optimierung-Spezialsysteme außer Acht lässt).

- Systeme mit < 50 Qubits,

- Systeme mit > 50 Qubits,

- NISQ – also Noisy-Intermediate-Scale-Quantum-Technologien, und

- Systeme ab 1 Mio. Qubits mit kompletter Fehlerkorrektur und komplett freier Programmierung.

Derzeit herrscht Konsens darüber, dass wir uns am Ende der NISQ-Phase oder auch schon wirklich zwischen der NISQ- und der > 1Mio Qubit Phase befinden.

Um auf das Phänomen „Store Now, Decrypt Later“ (oder auch „harvest now, decrypt later“) zurückzukommen, ist es für die zukünftige Datensicherheit von entscheidender Bedeutung, bereits heute Quanten-Verschlüsselungstechnologien einzusetzen. Zu diesem Zweck führt das NIST (US National Institute of Standards and Technology) mehrere Runden zur Zertifizierung solcher Algorithmen durch. Die in der ersten Runde ausgewählten Algorithmen wurden in relativ kurzer Zeit weitgehend geknackt. Die gerade begonnene zweite Auswahlrunde, die etwas länger dauern dürfte als die erste, wurde im April von einem mehr oder weniger zufällig geknackten Algorithmus, der eigentlich als quantum-safe galt, überrascht. Es wird wohl noch einige Zeit dauern, bis sichere Post-Quantum-Kryptographie als gesichert und etabliert angesehen werden kann.

Die derzeit auf Datensicherheit im Post-Quantum-Zeitalter spezialisierten Beratungsunternehmen sprechen ganz allgemein von einer erforderlichen Krypto-Agilität, nach der Unternehmen bereits heute damit beginnen sollten, ihre Datenbestände in verschiedene Risikoklassen einzuteilen und insbesondere die „datentechnischen Kronjuwelen“ des Unternehmens bereits jetzt mit vermeintlich sicheren Post-Quantum-Krypto-Algorithmen zu verschlüsseln. Generell wird ein hybrider Ansatz empfohlen: (a) klassische Verschlüsselung mit AES 256 (statt 48) und zusätzlich mit Post-Quantum-Krypto-Verfahren. Denn „its all about data!“ Die alte Erkenntnis, dass Daten länger leben als die meisten Speicher, auf denen sie gespeichert sind, als die Prozessoren, mit denen sie verarbeitet werden, und als die Anwendungen, die sie erzeugen und verändern, behält gerade im Zeitalter der KI oder der neuen EU-Datenschutzgesetzgebung ihre Gültigkeit.

Unternehmen, die bereits erste Schritte zur Bestandsaufnahme ihrer Datenbestände unter PQC-Aspekten unternommen haben, stellen fest, dass dies mit einem ziemlich hohen Aufwand verbunden ist. Dies liegt unter anderem daran, dass die Daten, die aus eigenentwickelten Anwendungen stammen, in immer kürzeren Abständen neu erstellt oder angepasst werden, aber auch zunehmend durch zugekaufte Softwarekomponenten – insbesondere aus Cloud-Computing-Lösungen – verwaltet werden. Dabei zeigt sich, dass eine manuelle Katalogisierung praktisch unmöglich ist. Man ist daher auf eine massive Automatisierung und – aufgrund der vielen externen Schnittstellen zu anderen Unternehmen – auf eine Kooperation zwischen den Unternehmen angewiesen. Insbesondere Unternehmen, deren Daten eine überproportional lange Lebensdauer haben, sollten bei der PQC-orientierten Inventarisierung ihrer Daten an vorderster Front stehen. Dies sind z.B. Unternehmen, die zertifizierte Produkte besitzen – wie in der Medizintechnik – Banken und Versicherungen, aber auch die Automobilindustrie, da die durchschnittlich zu erwartende Lebensdauer eines Fahrzeugs inzwischen weit über zehn Jahre liegt und die Funktion der Fahrzeuge in hohem Maße von Software und insbesondere Daten abhängt. In der Konsequenz bleibt für die entsprechenden Verantwortlichen in den Unternehmen nur eine konsequente Priorisierung der Vorhaben zur Erreichung der Krypto-Agilität, um eine Datenkategorie-abhängige Risikobewertung vornehmen zu können. Letztendlich werden diese Projekte zu einer dynamischen CBOM (cryptographic bill-of-material) führen.

Zusammenfassung und Empfehlung:

Quantum-Computing-Technologien münden derzeit noch nicht in einen singulären, konvertierenden Entwicklungsstrang. Diskontinuitäten in der Entwicklung können zu einer überraschenden Beschleunigung der Verfügbarkeit von frei programmierbaren und fehlerfreien Quantencomputern führen. Das Phänomen von „Store Now, Decrypt Later“ zwingt Unternehmensverantwortliche, bereits heute in Vorleistung zu gehen und PQC-sichere Algorithmen auszuwählen und zu verwenden, um den Kern des Datenschatzes ihres Unternehmens zu schützen. Notwendigen Maßnahmen zur Krypto-Agilität verlangen eine Inventarisierung /Bestandsaufnahme der Daten und der PQC-Risikobewertungsmaßnahmen, die besser heute als morgen beginnen sollten.